La tecnología 5G se está introduciendo poco a poco en nuestra vida y, como el término se utiliza cada vez más, hemos pensado que es hora de ayudarle a entender de qué se trata realmente.

Lee Woodland, director de producto de Airbus Secure Communications, ha pasado más de 20 años trabajando en telecomunicaciones comerciales fijas y móviles. Ahora es el principal director de producto de las comunicaciones inalámbricas tácticas y ha dirigido el desarrollo de Everus, un nodo de comunicaciones celulares tácticas 4G. Lee nos habla de los fundamentos clave de la tecnología 5G y de lo que podemos esperar en el futuro.

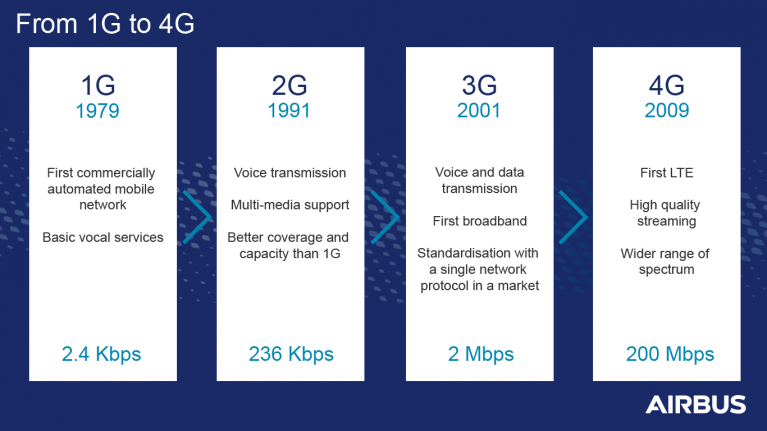

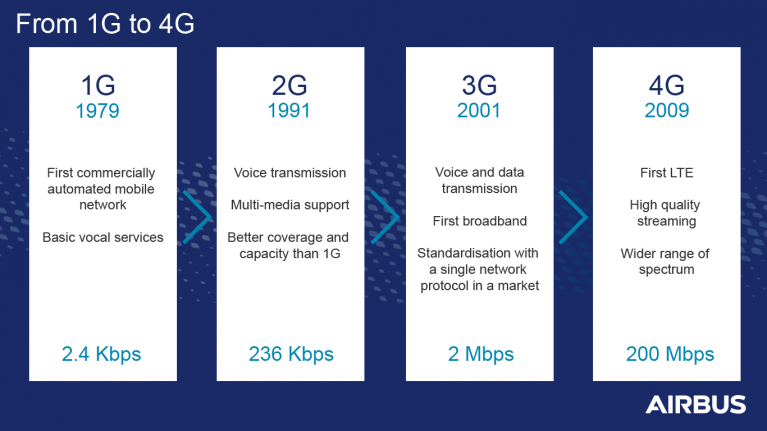

Al principio... 1G en 1979

La 1G, o primera "generación", fue la primera red móvil comercialmente automatizada. Lanzada en Tokio por Nippon Telegraph and Telephone (NTT), pronto se amplió para cubrir toda la población de Japón en 1979.

A pesar de ser increíblemente cara, la adaptación fue extremadamente rápida. Era evidente que el potencial de la tecnología era enorme, pero todavía había algunos problemas evidentes que debían resolverse, como la mala calidad de sonido y cobertura, incompatibilidad con otras redes 1G debido a los diferentes rangos de frecuencias, ausencia de itinerancia entre distintos operadores, sólo permitía el audio, y escasa seguridad debido a la ausencia de soporte para el cifrado. Además, esta tecnología era bastante cara y no estaba pensada para el gran público.

En 1991, la 2G: la revolución de la movilidad

La segunda generación de redes móviles se originó en Finlandia en 1991. Lanzada bajo el Sistema Global de Comunicaciones Móviles (GSM), la 2G trajo un estándar inalámbrico muy superior a lo que ofrecía la 1G; la mayor revolución fue el soporte de multimedia y no sólo de voz. También tenía una mejor cobertura y capacidad que la tecnología 1G.

El siguiente cambio más importante fue el cultural: la gente empezó a utilizar mensajes de texto, imágenes e incluso vídeos.

Aun así, la 2G tenía algunas limitaciones importantes, sobre todo porque sólo ofrecía velocidades de hasta 236 Kbps.

3G en 2001: la transición a una mejor conectividad

Lanzada en 2001 por NTT DoCoMo, la 3G supuso esencialmente la revolución de la "conmutación de paquetes", asegurando una conectividad mucho mejor para los "paquetes de datos" que impulsan la conectividad a Internet. Uno de los principales motores de la 3G fue la estandarización. El objetivo de la 3G era ofrecer un único protocolo de red en un mercado que había estado plagado de diferentes proveedores y protocolos. Esta estandarización permitía servicios de itinerancia internacional y la posibilidad de acceder a los datos desde cualquier lugar del mundo. Tenía una capacidad de 2Mbps y estaba claramente hecha para el uso de Internet y el intercambio de multimedia.

Además, la enorme capacidad de transferencia de datos abrió el camino a una serie de nuevos servicios basados en Internet, como la voz sobre IP (por ejemplo, Skype), las videoconferencias y el streaming, así como los servicios basados en la localización. La era de la 3G también supuso la introducción del Blackberry, el iPhone y otros "smartphones". Estos dispositivos cambiaron radicalmente la forma de utilizar el antiguo teléfono móvil al transformarlo en una mini computadora móvil.

En 2009, el 4G: Los datos de los smartphones de hoy

La primera versión del estándar 4G Long Term Evolution (LTE) se desplegó comercialmente en Oslo y Estocolmo en 2009. Desde entonces se ha extendido rápidamente por casi todo el mundo, incluido Estados Unidos. Con velocidades de datos teóricas de 200Mbps, esta generación de redes hace que el streaming de alta calidad sea una nueva realidad.

El 4G también abordó uno de los factores históricamente limitantes del 2G y el 3G, ésta es una mayor amplitud del espectro de frecuencias que utiliza el 4G. Este es un tema que se trasladará al 5G.

Ahora que hemos entendido de dónde viene el 5G, esté atento a nuestro próximo artículo que explica los cambios que implica el 5G.

Topics:

Airbus,

Blog,

MXLINK